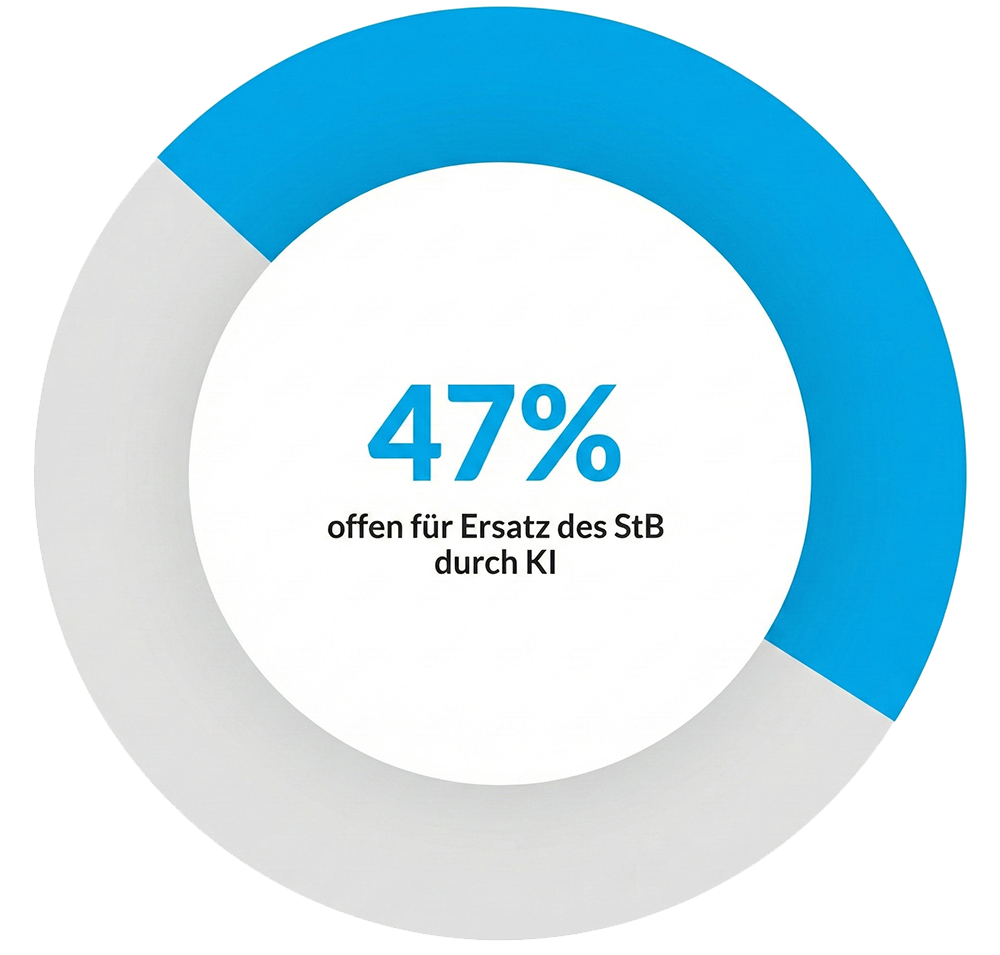

47 Prozent der Deutschen sind bereit, ihren Steuerberater gegen eine Software zu tauschen. Was wie eine digitale Revolution klingt, ist in Wahrheit ein Ritt auf der Rasierklinge. Eine aktuelle Erhebung von BuchhaltungsButler und DataPulse Research zeigt eine erschreckende Sorglosigkeit: Besonders Gutverdiener und junge Menschen vertrauen blind darauf, dass generative KI ihre komplexen Steuerfälle löst.

Die Verlockung ist riesig. Die durchschnittliche Rückerstattung liegt bei über 1.000 Euro, doch die Bürokratie ist zermürbend. Anekdotische Erfolgsgeschichten aus Foren wie Reddit befeuern den Hype weiter. Nutzer berichten dort, wie sie mit KI-Unterstützung Zeit sparen und komplexe Sachverhalte in einfache Sprache übersetzen lassen.

Doch diese Anekdoten verschweigen das systemische Risiko. Wer seine Steuererklärung einem Chatbot überlässt, spielt Russisch Roulette mit dem Finanzamt. Die Fehlerquote ist nicht nur hoch, sie ist strukturell bedingt.

Sprachmodelle erfinden Gesetze und Gerichtsurteile völlig frei

Das fundamentalste Missverständnis liegt in der Funktionsweise der Technologie. ChatGPT ist kein Wissensspeicher, sondern eine Wahrscheinlichkeitsmaschine. Das System sagt nicht die Wahrheit, sondern berechnet das nächste logische Wort. Maxin Schneider, CEO von BuchhaltungsButler, warnt eindringlich: Die KI klingt oft absolut überzeugend, selbst wenn sie völligen Unsinn erzählt.

Dieses Phänomen der „Halluzination“ ist keine Kinderkrankheit, sondern ein Feature. Im Steuerrecht, wo es auf präzise Paragrafen ankommt, ist das fatal. Die KI erfindet Gesetzesverweise, die plausibel klingen, aber schlicht nicht existieren.

Wie real diese Gefahr ist, zeigt ein aktueller Beschluss des Amtsgerichts Köln vom 2. Juli 2025. Ein Rechtsanwalt hatte ungeprüft einen von KI generierten Schriftsatz übernommen. Das Gericht stellte trocken fest, dass die zitierten Voraussetzungen frei erfunden waren. Was im Zivilprozess peinlich ist, wird im Steuerrecht teuer.

Rechenfehler und fehlendes Kontextwissen vernichten Steuererstattungen

Ein Sprachmodell ist kein Taschenrechner. ChatGPT scheitert regelmäßig an profanen Aufgaben wie Rundungen, Zwischensummen oder der korrekten Anwendung von Steuersätzen über lange Chatverläufe hinweg. Es fehlt das logische Verständnis für mathematische Abhängigkeiten.

Ein warnendes Beispiel liefert der Fall des Freelancers Hernan Barahona. Er verließ sich auf die KI, um seine Steuererklärung zu erstellen. Das System erklärte ihm zwar geduldig Grundbegriffe, versäumte es aber, ihn auf die Gewerbesteueranrechnung hinzuweisen.

Dieser Fehler hätte ihn fast 4.000 Euro gekostet. Die KI erkennt keine „negativen Signale“ und warnt nicht vor ungenutzten Potenzialen, weil sie keinen strategischen Gesamtüberblick hat. Sie arbeitet Textbausteine ab, anstatt den finanziellen Kontext zu analysieren.

Der vermeintliche Super-Prompt ersetzt kein steuerliches Fachwissen

In der Tech-Szene hält sich hartnäckig der Irrtum, alles sei nur eine Frage des richtigen „Prompts“. Das ist falsch. Um der KI die korrekten Anweisungen zu geben, benötigt der Nutzer bereits fundiertes steuerliches Grundwissen.

Wer nicht weiß, welche Pauschalen aktuell gelten oder wie Verluste verrechnet werden können, kann nicht die richtigen Fragen stellen. Steueroptimierung ist eine Strategie, keine Textaufgabe. ChatGPT fehlen verlässliche Rechtsquellen und der Zugriff auf aktuelle Datenbanken wie LEXinform.

Zudem erkennt die Software keine Widersprüche in den Eingaben. Während ELSTER oder professionelle Steuersoftware bei Unplausibilitäten Alarm schlagen, nickt der Chatbot jeden logisch klingenden Unsinn ab. Das Resultat sind formale Fehler, die im besten Fall zu Rückfragen, im schlimmsten Fall zu einer Betriebsprüfung führen.

Sie haften persönlich für jeden Fehler der Software

Am Ende der Kette steht eine harte juristische Realität: Für die Richtigkeit der Steuererklärung haftet allein der Steuerpflichtige. Weder OpenAI noch Microsoft übernehmen Verantwortung für falsche Ratschläge ihrer Algorithmen.

Die Nutzungsbedingungen sind hier eindeutig. Auch der EU AI Act ändert nichts an der individuellen Haftung gegenüber dem Finanzamt. Wer blindlings KI-Texte in ELSTER kopiert, begeht potenziell Steuerverkürzung oder Steuerhinterziehung – auch wenn es Unwissenheit war.

Zusätzlich geben Nutzer sensibelste Finanzdaten an US-Unternehmen preis. Für Steuerberater wäre dies ein strafrechtlich relevanter Verstoß gegen die Verschwiegenheitspflicht. Privatpersonen sollten sich gut überlegen, ob sie ihre Vermögensverhältnisse auf ausländischen Servern verarbeiten lassen wollen.

KI ist ein mächtiges Werkzeug zur Recherche und Erklärung, aber als Steuerberater ist sie derzeit eine Fehlbesetzung. Wer Sicherheit will, braucht Expertise, keinen Chatbot.