Sparsame Rechenpower statt Gigahertz-Schlachten

Lange galt im Chipmarkt: schneller, größer, teurer. Doch die Spielregeln verändern sich – getrieben durch den explosionsartigen Anstieg des Energieverbrauchs in Rechenzentren.

Vor allem durch KI. Amazon, Google und Microsoft betreiben Serverparks, deren Strombedarf laut Internationaler Energieagentur fast dem Deutschlands entspricht. Tendenz: steigend.

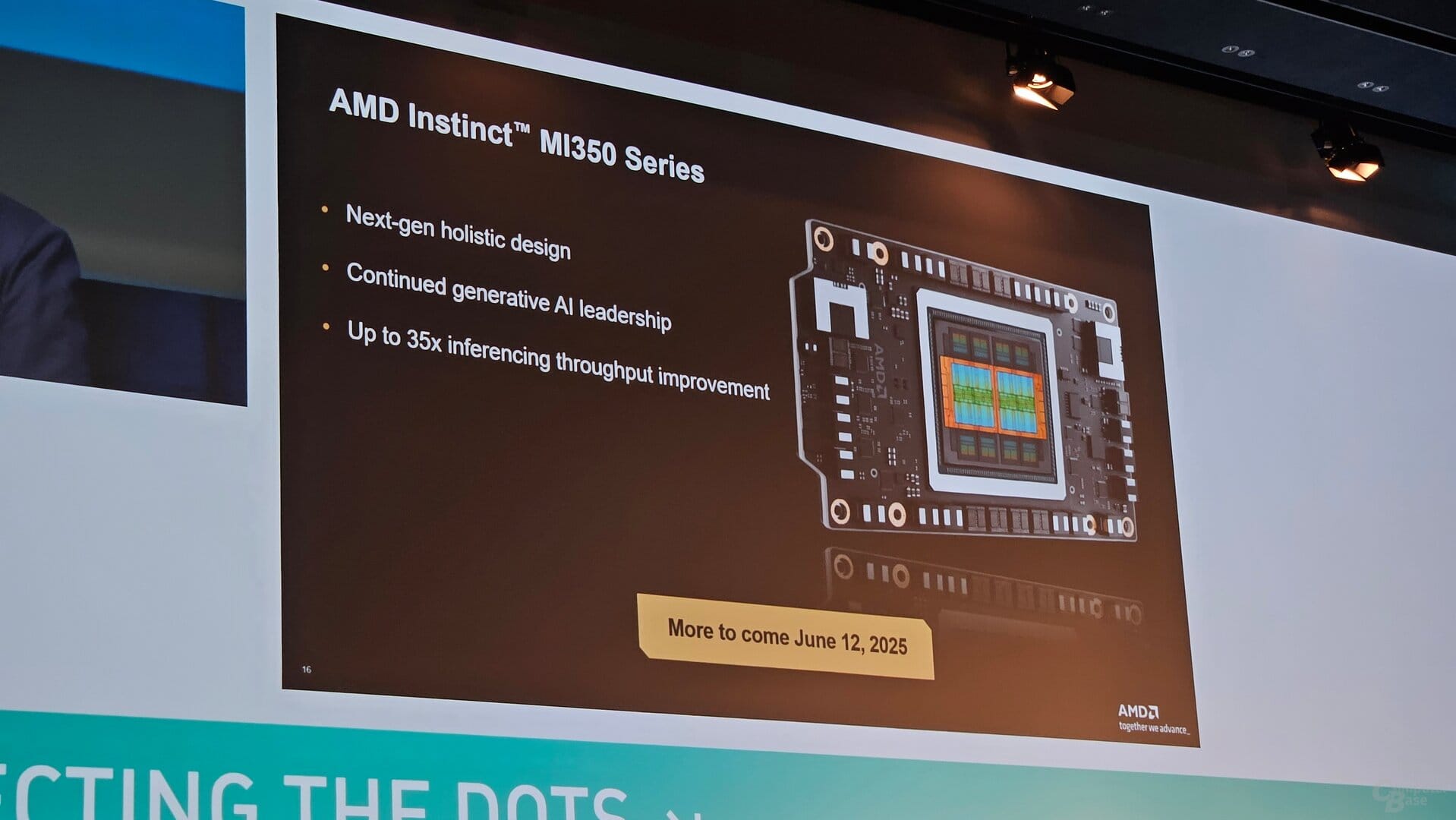

In dieser Gemengelage positioniert sich AMD neu – mit einem einfachen, aber strategisch mächtigen Versprechen: mehr Leistung pro Watt. Die neue MI350-Serie soll nicht nur effizienter rechnen, sondern auch günstiger sein als die High-End-GPUs von Nvidia. Es ist ein Frontalangriff auf den Marktführer – technologisch und politisch.

Lisa Su legt vor – in Zahlen und Taten

AMD-Chefin Lisa Su spricht offen von einem Paradigmenwechsel. Ihre Schätzungen zum KI-Chipmarkt sind ambitioniert: Bis 2028 soll er auf über 500 Milliarden Dollar anwachsen.

Zum Vergleich: Die gesamte Halbleiterindustrie kam 2024 auf rund 630 Milliarden. Künstliche Intelligenz wird zum neuen Zentrum der Chipwelt – und AMD will mitmischen.

Mit der MI350-Serie gelingt AMD ein technologischer Sprung: In internen Tests seien Nvidia-Chips nicht nur eingeholt, sondern in manchen Bereichen übertroffen worden. Vor allem bei Effizienz und Preis-Leistungs-Verhältnis.

Das Chiplet-Prinzip – AMDs strategischer Hebel

Herzstück der neuen Architektur ist die Aufteilung des Prozessors in spezialisierte Einzelteile, sogenannte Chiplets. Statt einen riesigen Monolithen zu bauen wie Nvidia, setzt AMD auf modulare Mini-Chips, die einzeln optimiert und kostengünstiger gefertigt werden können.

Das bringt mehrere Vorteile:

- Funktionen wie Speicheranbindung und Datenkommunikation laufen auf eigenen Einheiten – effizienter und passgenau.

- Unterschiedliche Fertigungstechnologien können parallel genutzt werden – das reduziert Abwärme und Stromverbrauch.

- Die 3D-Stapelung der Komponenten senkt die Signalwege, was die Energieverluste nochmals deutlich reduziert.

Laut Technikchef Mark Papermaster ergibt sich daraus ein massiver Effizienzgewinn: Die Rechenleistung pro Watt sei beim MI350 um das 38-Fache gegenüber der vorherigen Generation gestiegen. Ein bemerkenswerter Wert – wenn er sich in der Praxis bestätigt.

Wettbewerbsvorteil oder Wunschdenken?

Noch ist AMD hinter Nvidia zurück – vor allem beim Systemgeschäft. Nvidia verkauft längst komplette KI-Server mit perfektem Zusammenspiel von Hard- und Software. Das hauseigene CUDA-Framework hat sich als Branchenstandard etabliert und vereinfacht Entwicklern die Arbeit massiv.

AMD dagegen bietet ROCm – eine offene, aber weniger verbreitete Alternative. Der Rückstand im Software-Ökosystem ist erheblich. Auch die enge Verzahnung von Hardware und Serverinfrastruktur fehlt bislang.

Doch AMD hat reagiert: Mit der Übernahme von ZT Systems – einem Spezialisten für Serverbau – und der Neuentwicklung des Systems „Helios“ will der Konzern nun ebenfalls Komplettlösungen anbieten. Der Fokus liegt dabei klar auf Energieeinsparung im Gesamtsystem – vom Chip bis zur Kühlung.

Erster Härtetest: Meta und xAI steigen ein

Ein wichtiges Signal kam auf der Entwicklerkonferenz im Juni: Meta (Facebook) und Elon Musks xAI setzen bereits erste MI350-Chips ein. Das zeigt: AMD ist kein Papiertiger. Die Technologie wird getestet – in realen Rechenzentren.

Ob die Chips auch langfristig bestehen, hängt aber von zwei Dingen ab: der Performance im Dauerbetrieb – und der Frage, wie schnell AMD es schafft, ein konkurrenzfähiges Software-Ökosystem um ROCm aufzubauen.

Nvidia bleibt vorerst vorn – aber der Abstand schrumpft

Die Analysten von Jefferies sehen Nvidia weiterhin im Vorteil. Der Konzern kann höhere Preise verlangen, weil seine Systeme über die gesamte Lebensdauer wirtschaftlicher arbeiten – und weil das Entwickler-Ökosystem nahtlos funktioniert. CUDA ist nicht nur ein technischer Vorteil, sondern ein Kundenbindungsinstrument.

Aber: AMDs technische Fortschritte, insbesondere bei der Energieeffizienz, könnten den Druck auf Nvidia erhöhen – vor allem in Märkten mit hohen Stromkosten. Wenn der Stromverbrauch eines KI-Rechenzentrums zur Geschäftsgrundlage wird, wie etwa in Deutschland oder Japan, zählt jedes eingesparte Watt.

Helios – das große Wagnis

Der nächste große Schritt für AMD heißt Helios. Benannt nach dem griechischen Sonnengott soll das System nicht nur Chips, sondern ganze Serverlösungen anbieten – mit dem Fokus auf Energieeffizienz und Modularität. Die Strategie: Weniger Strom pro Rechenschritt, weniger Verlust durch Kühlung, smarteres Zusammenspiel der Komponenten.

Damit zielt AMD direkt auf die Rechenzentren der Zukunft – wo nicht nur rohe Leistung, sondern Nachhaltigkeit zählt. Ob Helios zum Gegengewicht zu Nvidias DGX-Systemen werden kann, bleibt abzuwarten. Noch fehlt die breite Marktakzeptanz – doch technologisch scheint AMD bereit.

Das könnte Sie auch interessieren: